A Avaliação Heurística é um método de avaliação da usabilidade que consiste na análise de uma interface por especialistas, com base em um conjunto de princípios — ou heurísticas — de design. O objetivo é identificar problemas de usabilidade que possam dificultar a experiência do usuário.

O objetivo desta avaliação heurística foi identificar problemas de usabilidade no protótipo do aplicativo Pergunta Aí, a partir de um olhar especializado, estruturado com base nos princípios das 10 heurísticas de Nielsen.

A avaliação buscou verificar se a interface está alinhada às metas de design do projeto, que incluem:

Promover uma comunicação mais fluida e acessível entre alunos e professores;

Reduzir barreiras de participação em aula, principalmente para alunos tímidos ou inseguros;

Garantir uma experiência intuitiva, eficiente e confiável, tanto para quem envia quanto para quem gerencia dúvidas em tempo real;

Adaptar-se a diferentes perfis de usuários, respeitando suas necessidades e contextos de uso.

Para isso, o protótipo foi avaliado por membros externos ao grupo, que observaram interações propostas com base nas personas e cenários problemas desenvolvidos anteriormente, buscando pontos de fricção, violações de boas práticas e inconsistências na interface. A partir dos achados, foram extraídos insights valiosos e sugestões de redesign que poderão orientar melhorias futuras no produto.

A Avaliação Heurística foi conduzida por membros de um grupo externo ao nosso, conforme orientado pela disciplina. Para garantir uma análise embasada, os avaliadores receberam acesso a um conjunto completo de materiais sobre o projeto, incluindo:

O protótipo navegável da plataforma Pergunta Aí

As personas desenvolvidas

Os cenários-problema associados a cada persona

As principais tarefas esperadas no fluxo de uso

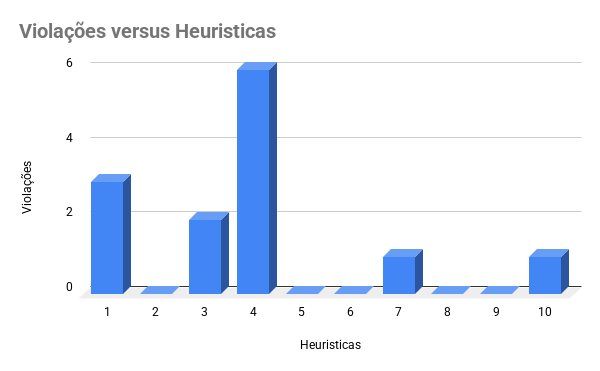

Com base nesses elementos, os avaliadores percorreram a interface identificando possíveis violações das 10 heurísticas de usabilidade de Nielsen. Para cada problema identificado, foi registrada a heurística violada, a localização na interface, uma descrição do problema e uma estimativa da gravidade com base em critérios como frequência, impacto e persistência.

Ao final do processo, consolidamos todas as observações recebidas em um documento único, categorizando os problemas e propondo sugestões de redesign para os principais pontos críticos identificados.

Foram utilizadas as 10 heurísticas de usabilidade propostas por Jakob Nielsen, entre elas:

Visibilidade do status do sistema

Correspondência entre o sistema e o mundo real

Controle e liberdade do usuário

Consistência e padrões

Reconhecimento em vez de memorização

Flexibilidade e eficiência de uso

Projeto estético e minimalista

Prevenção de erros

Ajudar usuários a reconhecer, diagnosticar e recuperar de erros

Ajuda e documentação

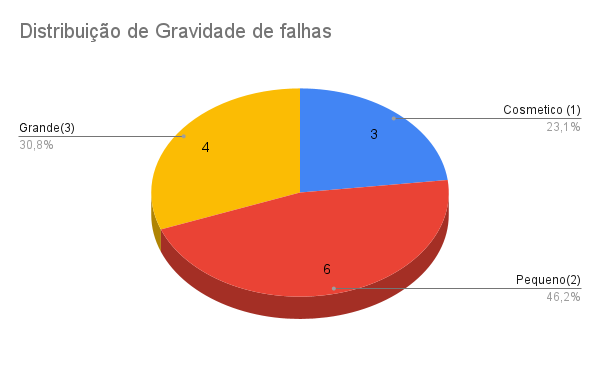

Cada problema foi classificado segundo a escala de severidade definida por:

1 – Cosmético: Não precisa ser corrigido a menos que haja tempo sobrando

2 – Pequeno: Pequeno problema de usabilidade, correção opcional

3 – Grande: Problema de usabilidade importante, deve ser priorizado

4 – Catastrófico: Deve ser resolvido antes de qualquer entrega do sistema

A severidade final leva em conta:

Frequência do problema

Impacto na experiência

Persistência do problema

A partir da Avaliação Consolidada, chegamos a alguns insights:

Com isso, tivemos algumas sugestões de melhoria:

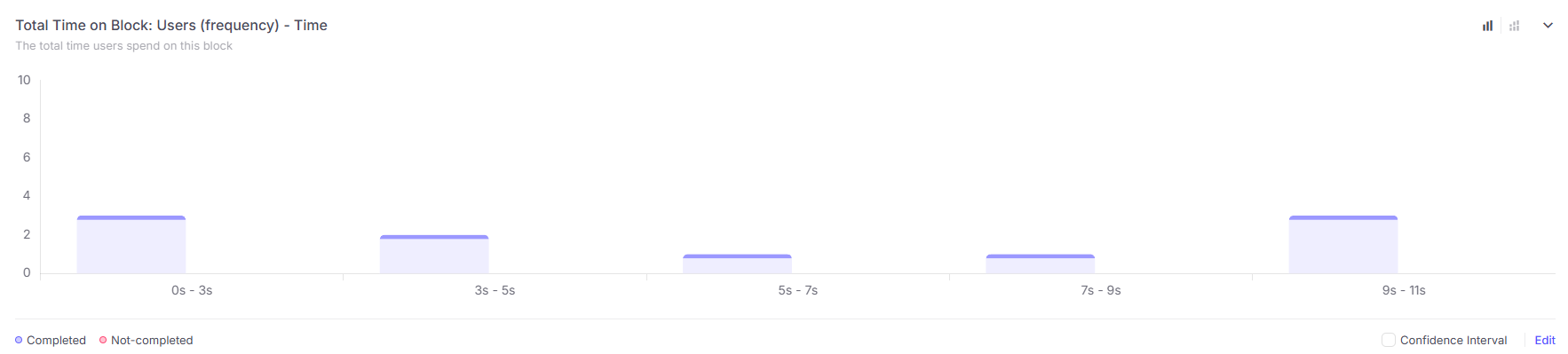

A técnica First Click é um método de avaliação de usabilidade que analisa o primeiro clique do usuário ao tentar realizar uma tarefa dentro de uma interface. O principal objetivo é verificar se esse clique inicial leva o usuário na direção correta para cumprir seu objetivo.

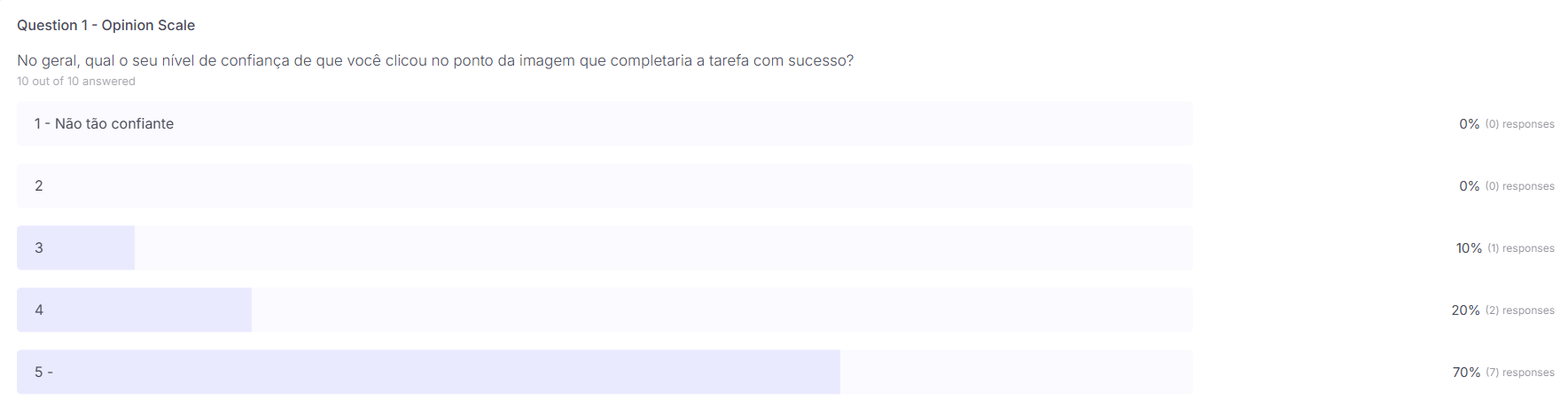

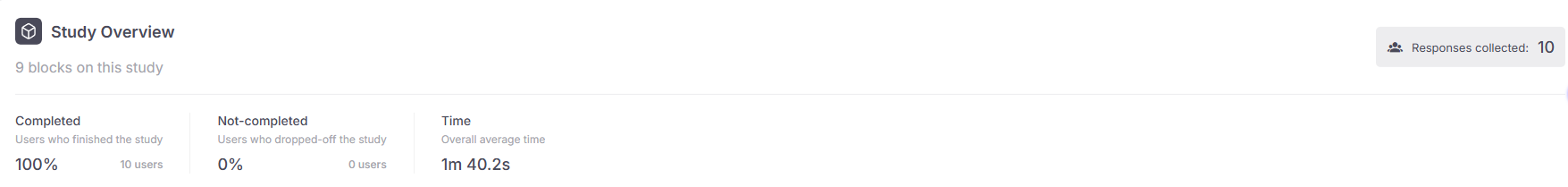

A ferramenta utilizada foi o Useberry com 10 participantes

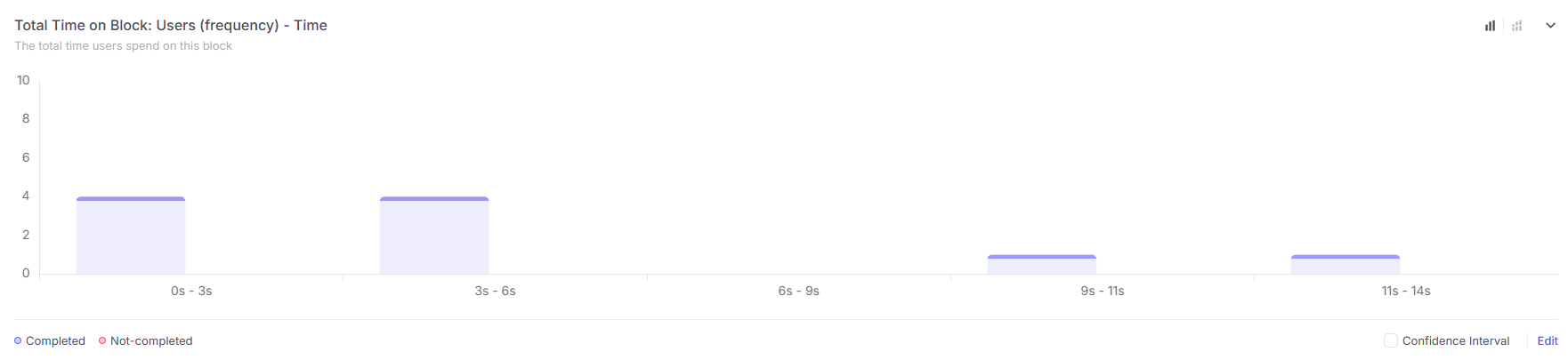

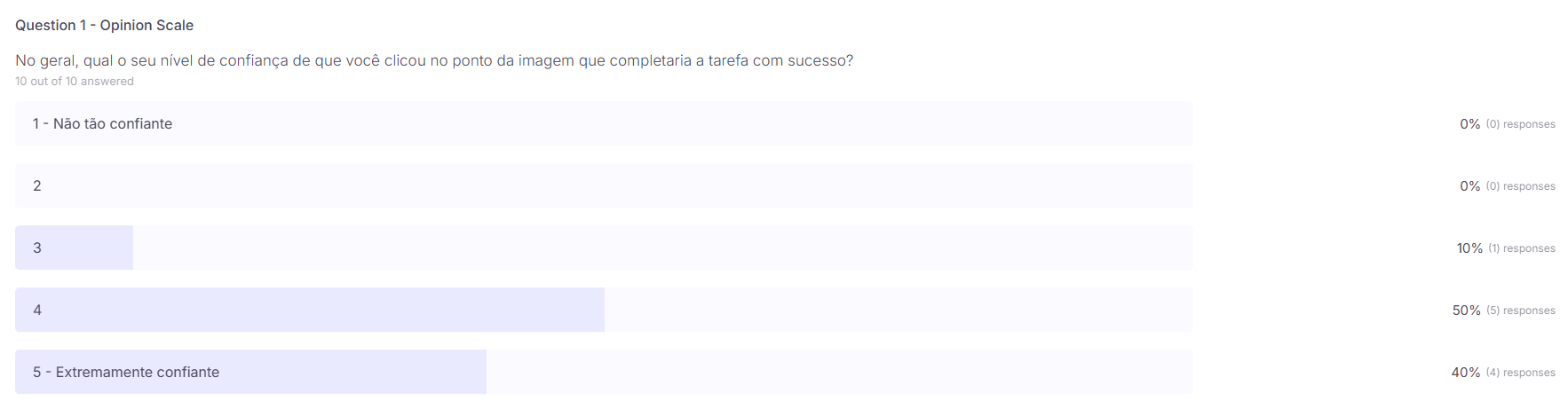

A avaliação foi conduzida com quatro tarefas distintas, apresentadas aos usuários por meio de cenários descritos em texto, com o objetivo de contextualizar e orientar a execução.

Todas as tarefas foram concluídas com sucesso pelos participantes. Após a realização dos testes, os dados foram extraídos utilizando a funcionalidade de Click Tracking, permitindo identificar precisamente os pontos clicados pelos usuários em cada tarefa.

Com base nesses dados, foram gerados gráficos e visualizações analíticas para embasar a análise da interface e avaliar a eficácia do design proposto.

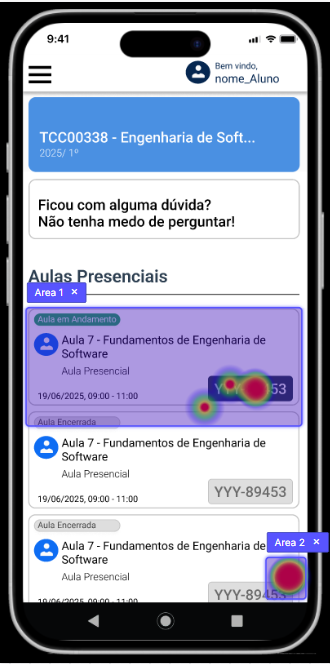

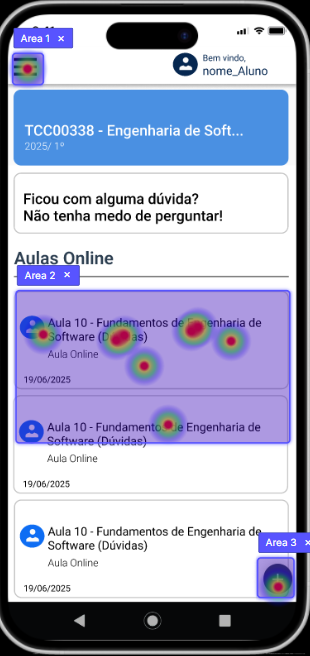

Imagine que você chegou em sala de aula, e precisa utilizar o código disponibilizado pelo professor para entrar em uma nova sessão de aula naquele horário, onde você clicaria para entrar em uma nova Aula Presencial?

Área 1: 5 cliques

Área 2 (A área correta): 5 cliques

Tempo médio: 6.6 segundos

Concluímos que a divergência aqui ocorreu por um cenário confuso, pois a imagem usada no teste apresenta um “Aula em andamento” por placeholder. Ao citar a necessidade de uma aula no horário atual, alguns não seguiram pelo caminho de entrar em uma nova aula e sim na que estava aberta naquele momento.

Visto que o problema veio do cenário, foi notado que caso melhor escrito esse caso de erro vai diminuir a um ponto eficaz, 8 usuários passaram a clicar no lugar certo.

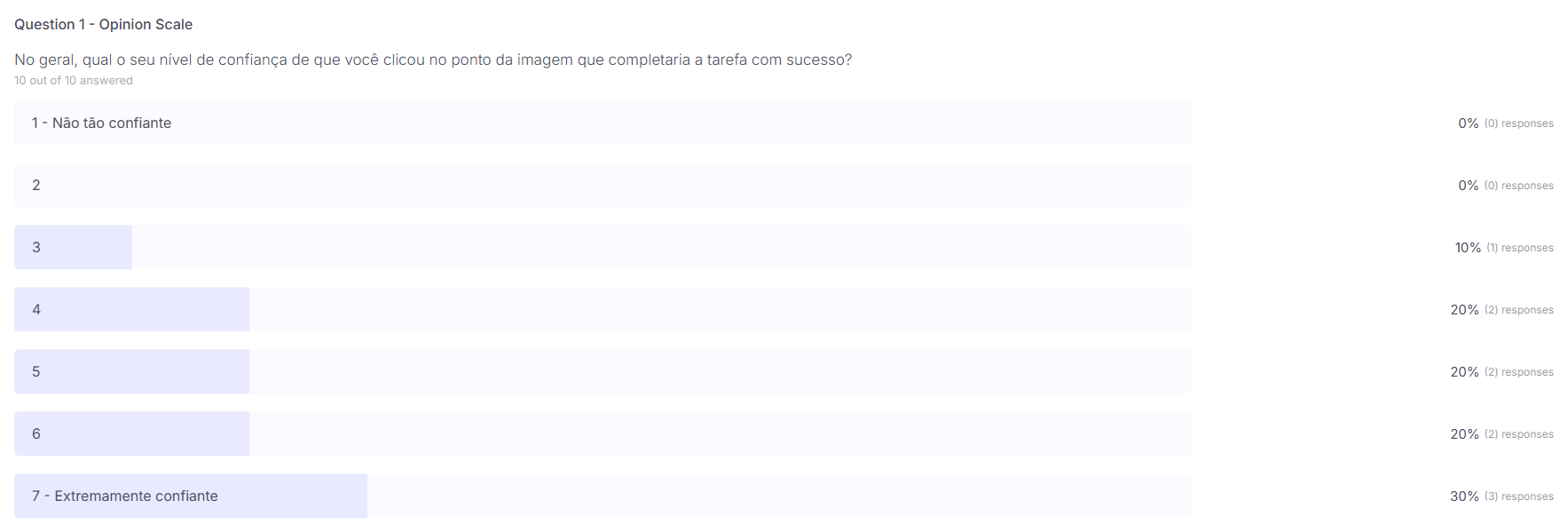

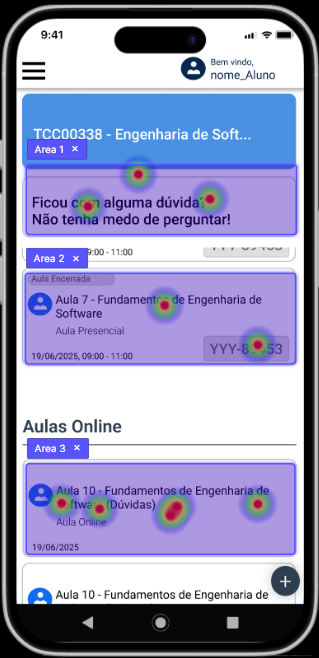

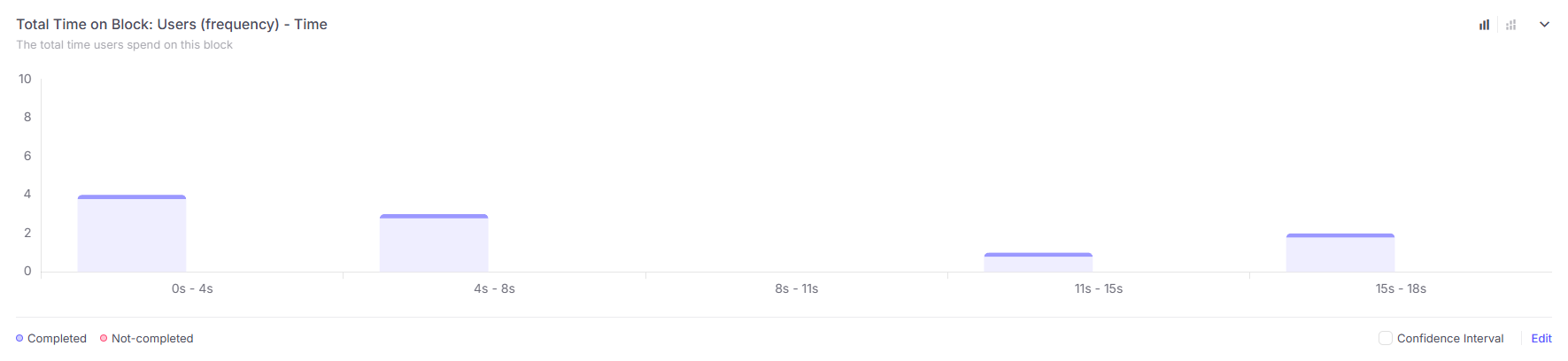

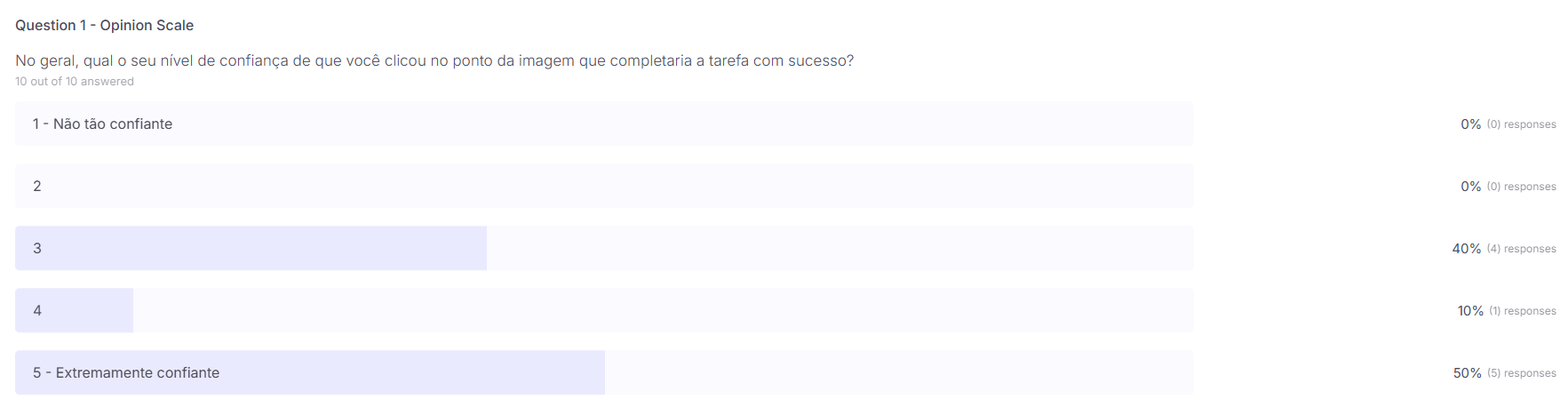

Imagine que você está utilizando o aplicativo e deseja escrever uma dúvida sobre um tópico online disponibilizado pelo professor, onde você acessaria essa parte?

Área 1: 3 cliques

Área 2: 2 cliques

Área 3 (A área correta): 5 cliques

Tempo médio: 4.3 segundos

Concluímos que a divergência aqui ocorreu primeiro pelo fato de não ter ficado claro a diferença entre uma aula online e uma presencial. Por fim o caso mais grave foi o fato do container com o texto “ficou com alguma dúvida?…” ser confundido com um botão.

A melhoria proposta seria retirar ou modificar o container superior que causou a diferença. Para o segundo erro devemos melhorar a visibilidade e deixar mais contrastante a diferença entre aula online e presencial para o usuário.

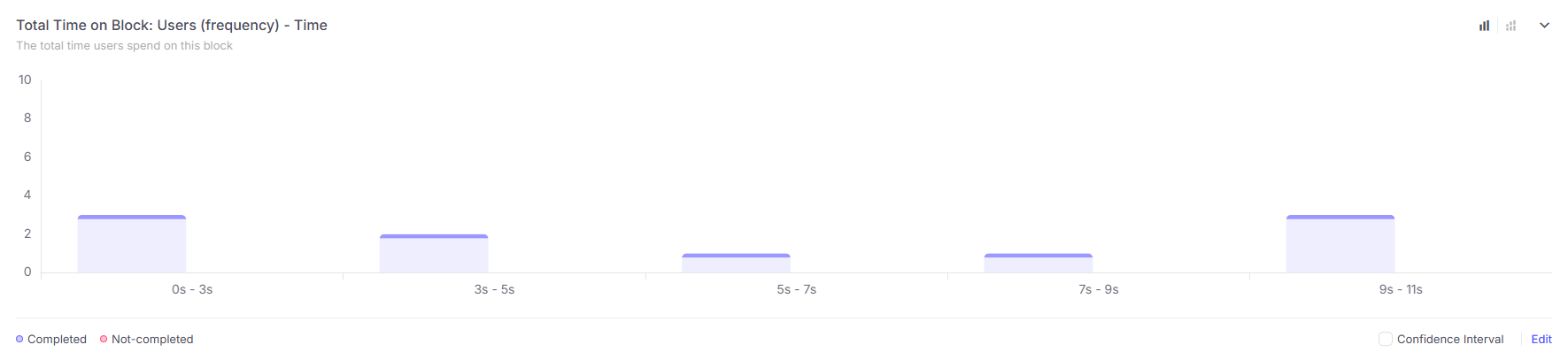

Imagine que você está estudando e vê que todas as dúvidas levantadas de um tópico criado pelo professor são pertinentes e você deseja testar seus conhecimentos em um minigame daquele tópico gerado por IA a partir das perguntas, onde você acha que deve acessar para chegar nesse meio?

Área 1: 1 clique

Área 2 (A área correta) 8 cliques

Área 3: 1 clique

Tempo médio: 6.7 segundos

Concluímos que a maioria dos 10 usuários acertaram o local, no entanto alguns ainda clicaram em lugares errados, o que significa que para usuários sem nenhum contexto do funcionamento do aplicativo pode ficar confuso o fluxo do aplicativo.

Embora a maioria acertou, vale a pena criar um tipo de ajuda seja por tutorial inicial ou um help que mostre o funcionamento do aplicativo para que os usuários não cometam esses erros, principalmente da localização das principais funções do app.

Imagine que você é um professor e deseja criar uma nova sessão presencial, onde você acredita que deveria ir para acessa-la.

Área 1: 1 cliques

Área 2: 1 cliques

Área 3: 1 cliques

Área 4 (A área correta): 7 cliques

Tempo médio: 4.7 segundos

Concluímos que a maioria dos 10 usuários acertaram o local, no entanto alguns ainda clicaram em lugares errados, o que significa que para usuários sem nenhum contexto do funcionamento do aplicativo pode ficar confuso o fluxo do aplicativo. Além disso a área 2 em especifico foi clicada pelo mesmo erro da tarefa 1 em que o fato da imagem ter uma aula em andamento confundiu o usuário.

Embora a maioria acertou, vale a pena criar um tipo de ajuda seja por tutorial inicial ou um help que mostre o funcionamento do aplicativo para que os usuários não cometam esses erros, principalmente da localização das principais funções do app. Além disso melhorar também como nas outras tarefas a explicação e contraste entre aula presencial e online.

Usuários típicos: Estudantes que cursam a disciplina e utilizam o sistema para acompanhar aulas e interagir com professores e colegas.

Passo 1. Aluno abre a tela inicial (dashboard) e vê a lista de turmas/matérias que está cursando.

Passo 2. Aluno clica na turma desejada e entra na tela da disciplina, onde aparecem duas sessões: “Aulas Online” e “Aulas Presenciais”.

Passo 3. Aluno desliza a tela até “Aulas Presenciais”, e clica em uma aula específica.

Passo 4. Aluno digita sua dúvida na barra de texto fixa ao rodapé da tela.

Passo 5. Aluno envia a dúvida clicando no ícone de enviar (seta) alinhado à barra de texto.

Passo 6. (Segundo Fluxo) — Se for em “Aulas Online”, aluno clica em “Faça sua pergunta”, preenche a caixa de texto que surge e clica em “Enviar”.

Q1. O usuário tentaria esta ação?

Sim. É o comportamento padrão: ao entrar no app, espera‑se ver suas turmas.

Q2. Ele perceberá que a ação está disponível?

Sim. Os cards de turmas estão centralizados e em destaque imediato.

Q3. Ele associará essa ação ao efeito correto?

Sim. Convenção de UX: clicar em um card de item leva aos detalhes desse item.

Q4. Ele receberá feedback apropriado após a ação?

Sim. O cabeçalho muda para o nome da turma, confirmando a navegação.

Q1. O usuário tentaria esta ação?

Sim. Para interagir, precisa escolher entre os modos de aula.

Q2. Ele perceberá que a ação está disponível?

Sim. As abas têm destaque de cor e aparecem logo abaixo do cabeçalho.

Q3. Ele associará essa ação ao efeito correto?

Talvez. “Online” e “Presenciais” remetem ao formato, não ao tipo de conteúdo (dúvidas).

Q4. Ele receberá feedback apropriado após a ação?

Sim. A aba ativa lista todas as aulas e seus títulos.

Q1. O usuário tentaria esta ação?

Sim. Ele viu as abas e quer acessar a seção de dúvidas presenciais.

Q2. Ele perceberá que a ação está disponível?

Sim. A aba é claramente clicável (cursor, leve sombreado).

Q3. Ele associará essa ação ao efeito correto?

Sim. Ao clicar em “Presenciais”, espera‑se ver conteúdo dessa categoria.

Q4. Ele receberá feedback apropriado após a ação?

Sim. A tab “Aulas Presenciais” fica destacada e a lista de dúvidas aparece.

Q1. O usuário tentaria esta ação?

Sim. A barra está sempre visível e convida à interação (“Escreva sua dúvida…” placeholder).

Q2. Ele perceberá que a ação está disponível?

Sim. Placeholder de texto e borda mais escura ao focar indicam área editável.

Q3. Ele associará essa ação ao efeito correto?

Sim. Barra na parte inferior com placeholder sugere que ele deve digitar aí.

Q4. Ele receberá feedback apropriado após a ação?

Talvez. Ao digitar, não há animação nem contagem de caracteres; o usuário pode não saber se o texto está sendo registrado.

Q1. O usuário tentaria esta ação?

Sim. Ícone de seta é convenção comum para “enviar” mensagens.

Q2. Ele perceberá que a ação está disponível?

Sim. O ícone destaca‑se em cor diferente ao passar o mouse.

Q3. Ele associará essa ação ao efeito correto?

Sim. Seta → “ir”/“enviar”.

Q4. Ele receberá feedback apropriado após a ação?

Não. O protótipo apenas limpa a caixa sem confirmação explícita.

Q1. O usuário tentaria esta ação?

Sim. Botão label “Faça sua pergunta” é autodescritivo.

Q2. Ele perceberá que a ação está disponível?

Sim. Botão ocupa área de destaque com borda ou preenchimento colorido.

Q3. Ele associará essa ação ao efeito correto?

Sim. O texto do botão indica claramente que abrirá um campo de pergunta.

Q4. Ele receberá feedback apropriado após a ação?

Não. A ação de envio não apresenta indicação de sucesso ou erro.

Usuários típicos: Professores que ministram a disciplina e utilizam o sistema para responder perguntas dos alunos.

Passo 1. Professor abre a tela inicial (dashboard) e vê a lista de turmas que ministra.

Passo 2. Professor clica na turma desejada e entra na tela da disciplina, com as abas “Aulas Online” e “Aulas Presenciais”.

Passo 3. Professor desliza até a aba “Aulas Online” e clica em uma aula específica.

Passo 4. Na lista de perguntas, o Professor clica na pergunta que deseja responder.

Passo 5. O professor clica no botão “Responder” centralizado na tela da pergunta.

Passo 6. Abre‑se uma caixa de texto; Professor digita a resposta.

Passo 7. O Professor clica novamente em “Responder” para enviar a resposta e vê a confirmação.

Q1. O usuário tentaria esta ação?

Sim. Ao entrar, espera‑se que o dashboard liste as turmas que ministra.

Q2. Ele perceberá que a ação está disponível?

Sim. Os cards de turma estão bem visíveis no centro da tela.

Q3. Ele associará a ação ao efeito correto?

Sim. Convenção de UX: card de curso → detalhes do curso.

Q4. Ele receberá feedback apropriado?

Sim. O cabeçalho muda para o nome da turma.

Q1. O usuário tentaria esta ação?

Sim. Precisa selecionar a turma para acessar o conteúdo.

Q2. Ele perceberá que a ação está disponível?

Sim. Ao passar o mouse, o card exibe hover e cursor muda.

Q3. Ele associará a ação ao efeito correto?

Sim. Ícone “>” no card reforça que é clicável.

Q4. Ele receberá feedback apropriado?

Sim. O painel é recarregado com as abas da disciplina.

Passo 3. Escolher “Aulas Online”

Q1. O usuário tentaria esta ação?

Sim. O docente sabe que perguntas são via online.

Q2. Ele perceberá que a ação está disponível?

Sim. A aba “Aulas Online” está destacada ao hover.

Q3. Ele associará a ação ao efeito correto?

Sim. Label autoexplicativa: perguntas online.

Q4. Ele receberá feedback apropriado?

Sim. A aba ativa muda de cor e lista de perguntas online aparece.

Q1. O usuário tentaria esta ação?

Sim. Quer ver o conteúdo e responder.

Q2. Ele perceberá que a ação está disponível?

Sim. Cada pergunta está em um card clicável.

Q3. Ele associará a ação ao efeito correto?

Sim. Card de pergunta → detalhes da pergunta.

Q4. Ele receberá feedback apropriado?

Sim. A tela exibe a pergunta com detalhes completos.

Q1. O usuário tentaria esta ação?

Sim. Botão está centralizado e label é claro.

Q2. Ele perceberá que a ação está disponível?

Sim. Cor de destaque e borda tornam-no visível.

Q3. Ele associará a ação ao resultado correto?

Sim. “Responder” sugere que abre um campo para resposta.

Q4. Ele receberá feedback apropriado?

Não. Não há animação ou mudança visual no botão após o clique.

Q1. O usuário tentaria esta ação?

Sim. Após clicar em “Responder”, espera‑se digitar ali.

Q2. Ele perceberá que a ação está disponível?

Sim. Caixa de texto aparece com placeholder “Digite sua resposta…”.

Q3. Ele associará a ação ao efeito correto?

Sim. Convenção de formulário: campo de texto → inserir conteúdo.

Q4. Ele receberá feedback apropriado?

Talvez. Não há contador ou borda que mude conforme digita.

Q1. O usuário tentaria esta ação?

Sim. Botão “Responder” permanece visível abaixo da caixa.

Q2. Ele perceberá que a ação está disponível?

Sim. Está destacado e habilitado após digitar.

Q3. Ele associará a ação ao efeito correto?

Sim. Label idêntica reforça que envia a resposta.

Q4. Ele receberá feedback apropriado?

Não. Após enviar, não há confirmação clara (ex.: toast).

Tarefa 3: Professor aprova uma resposta

Usuários típicos: Professores que precisam selecionar e destacar as melhores respostas dos alunos.

Passo 1. (Mesmo Passo 1 da Tarefa 2) Dashboard → lista de turmas.

Passo 2. Selecionar a turma → entrar na disciplina.

Passo 3. Desliza até “Aulas Online” e escolhe uma aula.

Passo 4. Selecionar a pergunta desejada.

Passo 5. Abaixo da caixa de “Responder” aparece a lista de respostas enviadas por alunos.

Passo 6. Ao lado de cada resposta, Professor clica no ícone “Aprovar” (✓).

Passo 7. A resposta aprovada recebe destaque visual (fundo ou borda colorida).

Q1. O usuário tentaria esta ação?

Sim. Para aprovar, precisa ver as respostas.

Q2. Ele perceberá que a ação está disponível?

Sim. As respostas aparecem em cards abaixo da caixa.

Q3. Ele associará a ação ao efeito correto?

Sim. Cards listam texto de cada resposta.

Q4. Ele receberá feedback apropriado?

Sim. Ao rolar a tela, sente que há conteúdo ali.

Passo 6. Clicar em “Aprovar”

Q1. O usuário tentaria esta ação?

Sim. Um ícone verde aparece ao lado de cada resposta sugere ação de validação.

Q2. Ele perceberá que a ação está disponível?

Talvez. O ícone é pequeno e sem hover definido, pode passar despercebido.

Q3. Ele associará a ação ao efeito correto?

Sim. O verde é convenção universal de “confirmar”/”aprovado”.

Q4. Ele receberá feedback apropriado?

Não. Não há indicação imediata de que a aprovação ocorreu (além da cor que pode demorar a aparecer).